Contexte

Les prix de la mémoire flash augmentent en flèche, et vont continuer d’augmenter dans les trimestres à venir. Les coupables sont tout désignés, non sans raison : les centres de calcul liés à l’Intelligence Artificielle, qui ont un besoin colossal en stockage et en mémoire vive pénalisant tout le monde, et qui ont déjà des répercussions préoccupantes, dont on ne peut qu’anticiper des effets de bord particulièrement désagréables (tout ce qui intègre une forme de mémoire ou une autre va voir son prix multiplier dans les semaines et mois à venir : téléphones, box TV, mais aussi matériel de makers, microcontrôleurs, etc.).

C’est la loi du marché : une ressource qui suscite un intérêt massif en peu de temps voit son tarif augmenter. La perspective — légitime — d’une pénurie ou d’une forte inflation de cette ressource n’est pas sans rappeler des cas similaires de l’histoire humaine, par exemple le blé, le riz, le papier toilette, ou pour rester dans le thème de l’informatique, les cartes graphiques, massivement employées dans le minage des cryptomonnaies.

Au-delà de l’augmentation des tarifs qui, en soi, n’a rien d’anormal, ce sont les stratégies déployées par les différents acteurs du marché, ainsi que leurs conséquences, qui fondent l’inquiétude de tous. Cependant, à la différence du blé ou du riz, qui sont des ressources naturelles et des biens de première nécessité, la mémoire électronique ne l’est pas, malgré notre dépendance à l’informatique.

Ce contexte, apparemment anxiogène, pourrait plutôt servir à se poser de meilleures questions quant à notre propre rapport à la mémoire. Si l’on se moque affectueusement et incorrectement de Bill Gates depuis 1981 pour la phrase “640 Ko devraient suffire à tout le monde”, il faut reconnaitre que cet apocryphe cache une réelle critique : l’illusion d’un besoin supérieur au besoin réel, ici en termes de mémoire, mais qui s’applique aussi au stockage informatique.

Le plateau de la mémoire

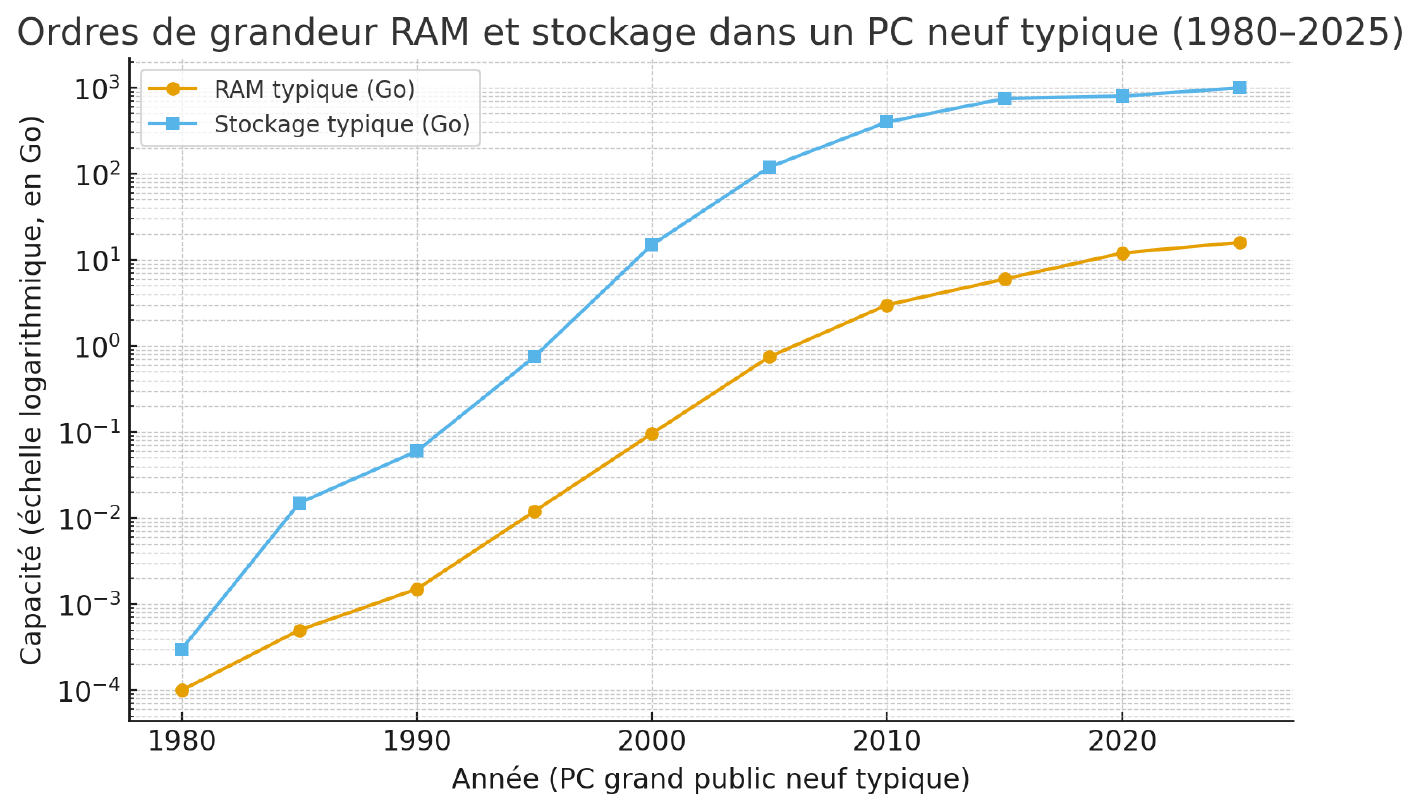

Bien qu’il n’existe aucune étude sérieuse sur la question (du moins, pas en accès libre), il est évident pour tout geek qui fait un peu de veille sur le matériel que la quantité de mémoire vive inclue dans les ordinateurs a suivi une progression fulgurante depuis les années 1990, avec une tendance au tassement ces dernières années. Par exemple, Apple intègre désormais un minimum de 16Go de mémoire vive dans ses ordinateurs, et les PC dotés de 32Go se trouvaient déjà à des tarifs raisonnables avant la crise de la mémoire. Le stockage a vu une évolution similaire chez le grand public ; là encore, il n’est pas rare de trouver des machines dotées de 1To de base, sans compter l’espace ajouté ultérieurement par les utilisateurs.

| Année | RAM typique (PC neuf) | Stockage typique (PC neuf) |

|---|---|---|

| 1980 | ≈ 0,0001 Go (64–128 Ko) | ≈ 0,0003 Go (1–2 disquettes, pas de disque dur) |

| 1985 | ≈ 0,0005 Go (256–640 Ko) | ≈ 0,015 Go (disque dur 10–20 Mo) |

| 1990 | ≈ 0,0015 Go (1–2 Mo) | ≈ 0,06 Go (40–80 Mo) |

| 1995 | ≈ 0,012 Go (8–16 Mo) | ≈ 0,75 Go (500 Mo–1 Go) |

| 2000 | ≈ 0,096 Go (64–128 Mo) | ≈ 15 Go (10–20 Go) |

| 2005 | ≈ 0,75 Go (512 Mo–1 Go) | ≈ 120 Go (80–160 Go) |

| 2010 | ≈ 3 Go | ≈ 400 Go (320–500 Go) |

| 2015 | ≈ 6 Go (4–8 Go) | ≈ 750 Go (500 Go–1 To) |

| 2020 | ≈ 12 Go (8–16 Go) | ≈ 800 Go (SSD 256–512 Go + éventuellement HDD 1 To) |

| 2025 | ≈ 16 Go (8 Go bas de gamme) | ≈ 1 To (SSD 512 Go–1 To sur la plupart des portables) |

Une infographie publiée par HP nous donne un aperçu général de ces évolutions, et vient confirmer le tableau ci-dessus, constitué avec l’aide de ChatGPT pour obtenir des estimations moyennes sur 5 ans depuis 1980.

Si l’on a effectivement atteint un plateau, la demande du grand public ralenti, les fabricants produisent moins. Et, soudainement, la demande grimpe, à des niveaux jamais vus. En août 2025, SK Hynix s’attendait déjà à une croissance annuelle de 30% des besoins en mémoire liés à l’IA, soit là où la rentabilité sera la plus forte ; c’est exactement la raison pour laquelle Micron a tué Crucial : le grand public n’est plus rentable.

Notons toutefois que le stockage à base de mémoire flash est relativement récent (en excluant évidemment les clés USB et autres cartes mémoire employées depuis très longtemps), et que son prix plus élevé que le stockage magnétique a sans doute freiné son adoption par le grand public, en tout cas pour les “grandes” capacités. Un disque dur coûte en moyenne 1.5 à 2 fois moins que son équivalent en mémoire flash — un ratio de 6:1 est même évoqué pour les entreprises. Ce coût est certainement à l’origine d’un “plateau du stockage flash”, qui devrait mathématiquement rester stable autour de 1To par machine grand public.

Ironiquement, les constructeurs de disques à plateaux (comme Seagate ou Western Digital) ont depuis bien longtemps recentré leur communication autour de solutions professionnelles (donc vendues plus cher), alors que dans le même temps, les constructeurs de supports à base de mémoire flash se sont plutôt orientés vers le marché grand public. Par ailleurs, de nombreux constructeurs inconnus jusqu’alors se sont engouffrés dans ce marché, avec des propositions très bon marché, tirant les prix vers le bas, au bénéfice du consommateur.

Dernier facteur intervenant dans le “plateau de la mémoire” théorisé ici : le cloud, et plus spécifiquement le stockage en ligne. Seagate estimait en 2018 qu’en 2025 la moitié de la datasphère se trouverait dans le cloud. Cette estimation a été dépassée en 2020 pour le grand public et en 2022 pour les entreprises, toujours selon Seagate, qui estime que cette tendance devrait se poursuivre.

Une analyse du piratage par l’Union Européenne datant de 2023 indique que la tendance est à la baisse. Il n’a pas été totalement endigué, notamment en raison de la fragmentation des plateformes de diffusion, de la suppression d’œuvres des catalogues, des contraintes régionales (des œuvres uniquement disponibles dans certains pays), etc. Mais les observations concordent vers une baisse du piratage, que l’on peut mécaniquement relier à une baisse des besoins en stockage des particuliers.

En conclusion, il parait évidant qu’un seuil est atteint, et les éléments que nous venons de voir nous ont prévenus depuis quelque temps. Le bon sens seul aurait pu suffire à nous alerter : rien, dans nos besoins personnels, indique que nous aurions dû voir une croissance continue dans la quantité de mémoire vive ou de mémoire de stockage embarquée par défaut dans les ordinateurs.

L’illusion du besoin

Le besoin croissant et durable en mémoire vive et en stockage (du grand public) est une illusion entretenue de nombreuses façons.

Tout d’abord, il y a le contexte historique : l’informatique avait légitimement besoin d’évoluer au cours de son histoire, mais on peut se demander si, aujourd’hui, ce besoin existe toujours. Un ordinateur compact et abordable est, en 2025, capable de faire tourner n’importe quel jeu ou presque, et est même capable d’exploiter des modèles d’Intelligence Artificielle localement. N’évoquons pas la bureautique dont l’impact sur la mémoire vive ou le stockage est négligeable, comparé à ces deux usages. Autrement dit : un ordinateur, en 2025, est capable d’accomplir n’importe quelle tâche que la majorité du grand public peut vouloir exécuter. L’argument d’avoir “plus de mémoire” ou un “plus gros disque dur” ne tient plus vraiment que de l’argument marketing.

Je n’omets pas “le grand public éclairé”, celui dont les besoins sont moins génériques, mais qui représentent une niche pour les constructeurs.

Ensuite, il y a les contextes marketing (proposer des machines “meilleures” que celles des concurrents), égotiste (“j’ai une meilleure machine que les autres”) et logiciel. Les trois co-évoluent et s’entretiennent mutuellement dans une spirale de la surenchère, sans prise en compte particulière des besoins réels. Un phénomène comparable au marché des supercars où le maître-mot est d’avoir la voiture la plus rapide sans pouvoir réellement exploiter cette puissance. La comparaison ne s’arrête pas là puisque, à l’instar de cette niche du marché automobile, on s’avance vers une niche du marché informatique grand public, peuplée non seulement des égotistes, mais aussi des passionnés et des expérimentateurs, qui seront propulsés malgré eux vers un luxe qu’ils n’ont jamais perçu comme tel.

Du point de vue des logiciels, les développeurs attendent du matériel capable de répondre à leur créativité, tandis que les fabricants de matériels cherchent à anticiper ces demandes. Le “logiciel” considéré ici doit être compris tant comme le système d’exploitation que les outils (dont l’IA, très exigeante en termes de mémoire vive) et que les jeux-vidéo, dont l’appétit (en termes de stockage) ne cesse de croitre.

Cependant, le streaming est en progression, notamment sur console, et devient même un pilier stratégique de Microsoft. Son adoption accélère, et les prévisions semblent plus prudentes que par le passé. Cela devrait conduire à du matériel de jeu moins bien équipé en mémoire et en stockage, puisque ces deux postes sont déportés sur le cloud. Le jeu sur ordinateur pourrait également suivre une tendance similaire, en particulier dans un contexte dans lequel la mémoire et le stockage ont un impact fort sur le prix de l’équipement, surtout si les propositions bare-bone1 deviennent de plus en plus populaires, comme cela pourrait être le cas sur le marché des mini-PC en raison de la crise.

Mais, finalement et selon moi, le facteur le plus contributif à l’illusion du besoin de stockage et de mémoire vient des utilisateurs eux-mêmes. Lorsque l’informatique évoluait plus vite (la pente ascendante de la courbe présentée plus haut), on avait peur de manquer de mémoire (le fameux adage “plus on a de mémoire vive, mieux c’est”) et de place (des compromis devaient être faits entre les performances et la capacité).

Ces craintes étaient légitimes dans ce contexte spécifique de l’évolution de l’informatique, mais elles ne le sont plus si l’on considère que l’on a atteint le plateau supposé dans cet article. Elles persistent, mais ne se justifient plus que par leur propre inertie (on pense que l’on va manquer parce qu’on l’a toujours pensé) ou la pression d’un besoin fantasmé.

Une rééducation vers la frugalité

Sur la mémoire vive

J’affirme, déjà depuis un moment, que 8Go de mémoire vive et 1To de stockage sont amplement suffisants à pratiquement n’importe qui. L’étude que j’ai réalisé pour les besoins de cet article va en ce sens : la quantité de mémoire installée dans les nouveaux ordinateurs stagne autour de 16Go, alors que 2To de stockage semblent devenir la norme, et ces deux quantités me paraissent surdimensionnées.

Puisque nous n’empêcherons pas la création de ces centres de données, ni leur exploitation, il y a, toujours selon moi, deux éléments principaux qui devraient permettre de respecter la “limite” que je propose :

- la sobriété des logiciels

- la rééducation des utilisateurs

À moins de faire pression sur les développeurs de logiciels (encore une fois, j’inclus dans ce terme les systèmes d’exploitation, les outils et les jeux-vidéo) pour les appeler à plus de sobriété, le grand public ne peut pas vraiment intervenir sur les besoins (réels ou imaginés) des applications qu’il utilise. En revanche, il peut adapter son propre comportement, de sorte à tendre vers une frugalité qui lui permettra d’esquiver la crise de la mémoire. J’utiliserai mon propre exemple à titre d’illustration, puisque je me considère comme un utilisateur avancé de l’informatique : mes besoins devraient donc être supérieurs à ceux du grand public.

Le principal obstacle à une consommation plus intelligente de son matériel est la contrainte d’observation : le grand public ne sait pas forcément comment vérifier sa consommation de mémoire vive, alors qu’il peut être automatiquement prévenu lorsque son support de stockage est plein.

Pourtant, les outils existent : le gestionnaire des tâches sous Windows, le moniteur de ressources sous macOS, la commande free sous GNU-Linux.

Tous ces outils ont un point commun : ils ne sont utilisés que par ceux qui n’ont pas peur de fouiller leur système et ses outils intégrés, alors que ce sont des ressources cruciales pour comprendre comment l’ordinateur exploite son matériel disponible.

Que serait un conducteur de voiture sans une jauge d’essence ou de batterie ?

Dans le contexte qui nous intéresse ici, la consommation en mémoire vive est la donnée la plus importante : combien de mémoire est installée, et combien est utilisée en conditions normales d’utilisation ? Le grand public, malheureusement, ne maitrise pas ces informations qui dépendent d’éléments complexes : la gestion de la mémoire vive (et surtout du swap) diffère d’un système à l’autre (non seulement aux niveaux les plus bas de leur conception, mais aussi du paramétrage par l’utilisateur). Là où une jauge de batterie ou de réservoir est un indicateur simple et direct pour lire l’autonomie d’un véhicule, l’utilisateur d’un ordinateur doit connaitre des concepts complexes et juger plusieurs indicateurs et leur évolution dans le temps pour savoir si son ordinateur a besoin de plus de mémoire.

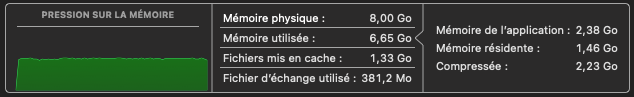

Or, les systèmes d’exploitation ont tendance à prendre ce qu’on leur donne : plus il y a de mémoire, plus ils prennent leurs aises (d’où l’adage évoqué précédemment). Par conséquent, toute métrique sur la mémoire tend à montrer qu’on est toujours en manque ! Si vous êtes un utilisateur un peu technique, vous remarquerez, sur la capture d’écran ci-dessus, que ma courbe de pression sur la RAM reste verte, et que mon fichier d’échange n’est pas vide, mais que 381Mo restent tout à fait raisonnables. Comment peut-on demander à un utilisateur grand public de savoir cela ? Et comment pourrions-nous représenter ces informations de façon plus simple (à l’instar d’une jauge de batterie) ? Ces deux questions appellent une réponse commune : c’est impossible.

free

total used free shared buff/cache available

Mem: 15853 2350 385 9 13460 13502

Swap: 7628 912 6716

La commande free sous GNU-Linux a un affichage plus simple, mais elle impose d’utiliser la ligne de commande, ce que ces systèmes cherchent précisément à éviter au grand public.

Néanmoins, je l’ai exécutée sur mon serveur (sur lequel est hébergé mon site, ainsi que plusieurs autres services que j’utilise réellement) afin de vous montrer sa frugalité, et que j’ai moi-même été victime de la surenchère au moment où je l’ai acquis.

Sur les 16Go de mémoire installée, il en utilise concrètement moins de 3Go.

Si l’information seule ne peut pas servir à l’utilisateur pour savoir s’il a besoin de plus de mémoire, il ne peut alors compter que sur son propre bon-sens, et adopter une certaine hygiène s’il se pose les bonnes questions :

- Aie-je besoin de laisser 35 onglets2 ouverts dans mon navigateur ?

- Quelles applications tournent en arrière-plan et pourquoi ?

- Existe-t-il une alternative plus sobre aux applications que j’utilise ?

Pour beaucoup, ces questions simples en apparence semblent représenter une charge mentale trop importante et préfèrent les ignorer plutôt qu’adopter des gestes simples, que j’ai déjà brièvement abordé sous l’angle de l’écoresponsabilité dans un article datant de 2021. Des gestes pourtant similaires à ceux adoptés dans la vie courante : si vous vous êtes habitués au tri sélectif, vous devez pouvoir vous habituer à fermer les onglets que vous ne consultez pas, par exemple.

Sur l’espace disque

La question de l’espace disque est plus simple que la mémoire vive dans la mesure où l’utilisateur dispose d’un indicateur clair de la quantité d’espace restant. Néanmoins, bien maitriser son espace disque est tout aussi problématique que gérer sa mémoire vive. Je pense pourtant que c’est dû à une question aussi simple que fondamentale, que le grand public ne se pose jamais : quelles données en ma possession ne sont pas reproductibles si je les perdais ?

J’ai vu trop de dossiers “Mes documents” ou “Téléchargements” remplis de fichiers téléchargés, depuis longtemps installés ou oubliés, trop de corbeilles jamais vidées, trop de dossiers portant un nom similaire, préfixés ou suffixés par une date comme autant de “copies de sauvegarde”, pour ignorer que le grand public ne sait pas gérer ses données. Peut-être est-ce de l’ignorance, de la fainéantise, ou, encore une fois, de la peur clinique, cette fois de supprimer quelque chose. Cette dichotomie est particulièrement intéressante : on a peur de manquer de mémoire vive alors qu’on en a déjà trop, et on a peur de supprimer ce dont on n’a pas besoin.

Combien, parmi les utilisateurs d’un ordinateur, disposent de plus de 4To de stockage, sans stocker des copies pirates de films, séries TV, jeux-vidéo ? Combien, parmi les non-joueurs, exploitent réellement 2To de stockage ? Regardez vos propres indicateurs, et demandez-vous si la quantité que vous voyez vous semble correspondre à des données que vous êtes absolument incapable de reproduire si vous les perdiez.

J’ai un Mac mini M2, 6 serveurs dédiés à diverses tâches, cinq tablettes, une centaine de périphériques domotique, des box TV, deux téléphones mobiles, un PC de jeu, et pourtant, l’intégralité des données présentes sur l’ensemble des supports de stockage de tout ce réseau ne représente que 73Go. Parce que ces 73Go ne sont pas reproductibles, au contraire des 450G demandés par ARK: Survival Evovled, des 60G demandés par mes outils et applications, des fichiers dans ma corbeille (c’est-à-dire, aucun), des fichiers dans mon dossier de téléchargement (aucun), des emails que je stocke en permanence dans ma boîte mail (aucun). Ces 73Go sont des données que j’ai produites, et qui ne sont pas reproductibles : mes articles, mes photos personnelles, les applications que j’ai développées, les documents administratifs que je dois conserver. Et encore, si je n’avais pas mon site, si je décidais de limiter mes autres services lancés sur mon serveur, cette quantité serait abaissée à une vingtaine de Go, et ne serait constituée que de photos personnelles.

Une grosse clé USB à moins de 20 euros serait suffisante pour stocker ma vie entière, du moins la partie que je ne pourrai pas reproduire en cas de perte. Faites le compte, mais pas avec l’ordinateur fourni par votre entreprise ; avec le vôtre, personnel.

Conclusion

Cette crise va évidemment avoir des conséquences fâcheuses sur toute l’informatique, et désigner des coupables ne va rien changer. En revanche, c’est le bon moment pour retrouver un usage raisonné de son informatique, plus sain, plus sobre, plus cohérent avec son exploitation réelle. Parce que, lorsque cette crise sera terminée, une fois les centres de calcul construits et exploités, la demande reviendra à des niveaux “normaux”. Et dès lors, est-ce qu’elle aura exacerbé notre peur de manquer, au point d’acheter des barrettes de mémoire ou des supports de stockage surnuméraires “au cas où”, quand bien même, nous savons que nous n’en avons pas besoin, ou bien serons-nous parvenus maitriser ces peurs et ces usages ?

-

Un ordinateur bare-bone est vendu “complet”, c’est-à-dire avec un boitier, un processeur, une alimentation, etc. mais sans mémoire vive et sans disque dur. ↩︎

-

Nombre choisi totalement par hasard. Je sais d’expérience que beaucoup d’utilisateurs n’ont aucun scrupule à garder des centaines d’onglets et des dizaines d’applications ouvertes, sans justification convaincante. ↩︎

Richard Dern

Richard Dern